UNIST, 손-물체 상호작용 AI ‘BIGS’ 개발

UNIST(울산과학기술원)가 단일 RGB 영상만으로 양손과 낯선 물체의 상호작용을 실시간 3D로 복원할 수 있는 인공지능(AI) 기술을 개발하며, 수술 시뮬레이션과 가상현실(VR) 분야의 진보를 예고했다.

백승렬 교수 연구팀은 새로운 AI 모델 ‘BIGS(Bimanual Interaction 3D Gaussian Splatting)’를 통해 손과 물체 간의 복잡한 상호작용을 정밀하게 구현할 수 있게 됐다고 9일 밝혔다.

BIGS는 카메라 한 대로 촬영한 2D 영상만을 활용해 손과 물체의 입체적 형태를 실시간으로 복원하는 AI 모델이다.

이 기술은 사전에 스캔된 데이터 없이도 처음 보는 기구와 양손의 움직임을 정확히 재현할 수 있다.

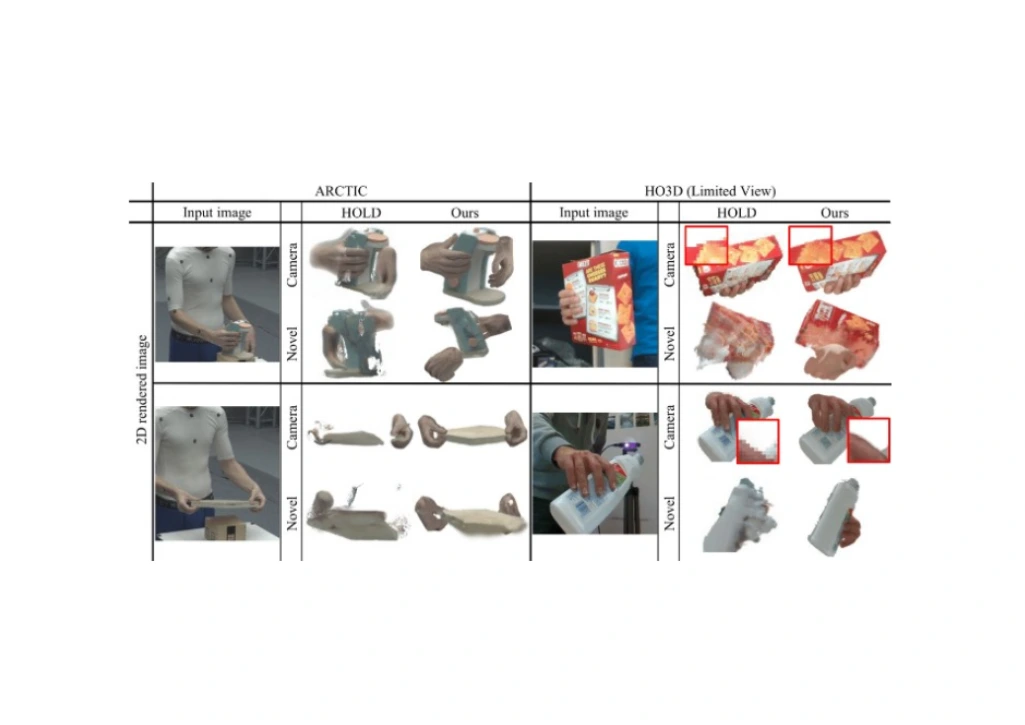

기존 기술이 한 손만 인식하거나 특정 물체에 한정됐던 것과 달리, BIGS는 양손과 미지의 물체 간 상호작용까지 시각적으로 구현한다.

핵심 기술은 ‘3D 가우시안 스플래팅’ 기반의 형상 복원이다.

가우시안 스플래팅은 물체를 퍼지는 점 형태로 표현해 손과 물체가 접촉하는 경계면을 더욱 자연스럽게 재현할 수 있다.

여기에 손의 구조를 정렬하는 ‘기준 손 구조(Canonical Gaussian)’ 방식과 보이지 않는 영역까지 복원하는 ‘SDS(Score Distillation Sampling)’ 기법을 적용해 영상의 한계도 극복했다.

UNIST 연구진은 이번 기술이 기존 AR·VR 기술은 물론, 원격 수술 시뮬레이션과 로봇 제어 등 다양한 산업에서 활용 가능할 것으로 보고 있다.

특히 단일 영상으로도 정밀한 3D 복원이 가능하다는 점에서 실용성이 매우 높다.

이번 연구는 UNIST 온정완 연구원이 제1저자로 참여했고, 곽경환, 강근영, 차준욱, 황수현, 황혜인 연구원이 공동으로 수행했다.

연구 결과는 세계 최고 권위의 컴퓨터 비전 학회 ‘CVPR 2025’에 채택돼, 오는 11일부터 미국에서 열리는 학회에서 발표될 예정이다.

백승렬 교수는 “이번 연구는 향후 가상현실(VR), 증강현실(AR), 로봇 제어, 원격 수술 시뮬레이션 등 다양한 분야에서 실시간 상호작용 복원 기술로 활용될 것으로 기대된다”고 강조했다.

배동현 (grace8366@sabanamedia.com) 기사제보